[](README.md)

[](#third-parry-resources)

[](#industry-application-models)

[](README.md)

[](#third-parry-resources)

[](#industry-application-models)

|

|  |

|  |

|  |

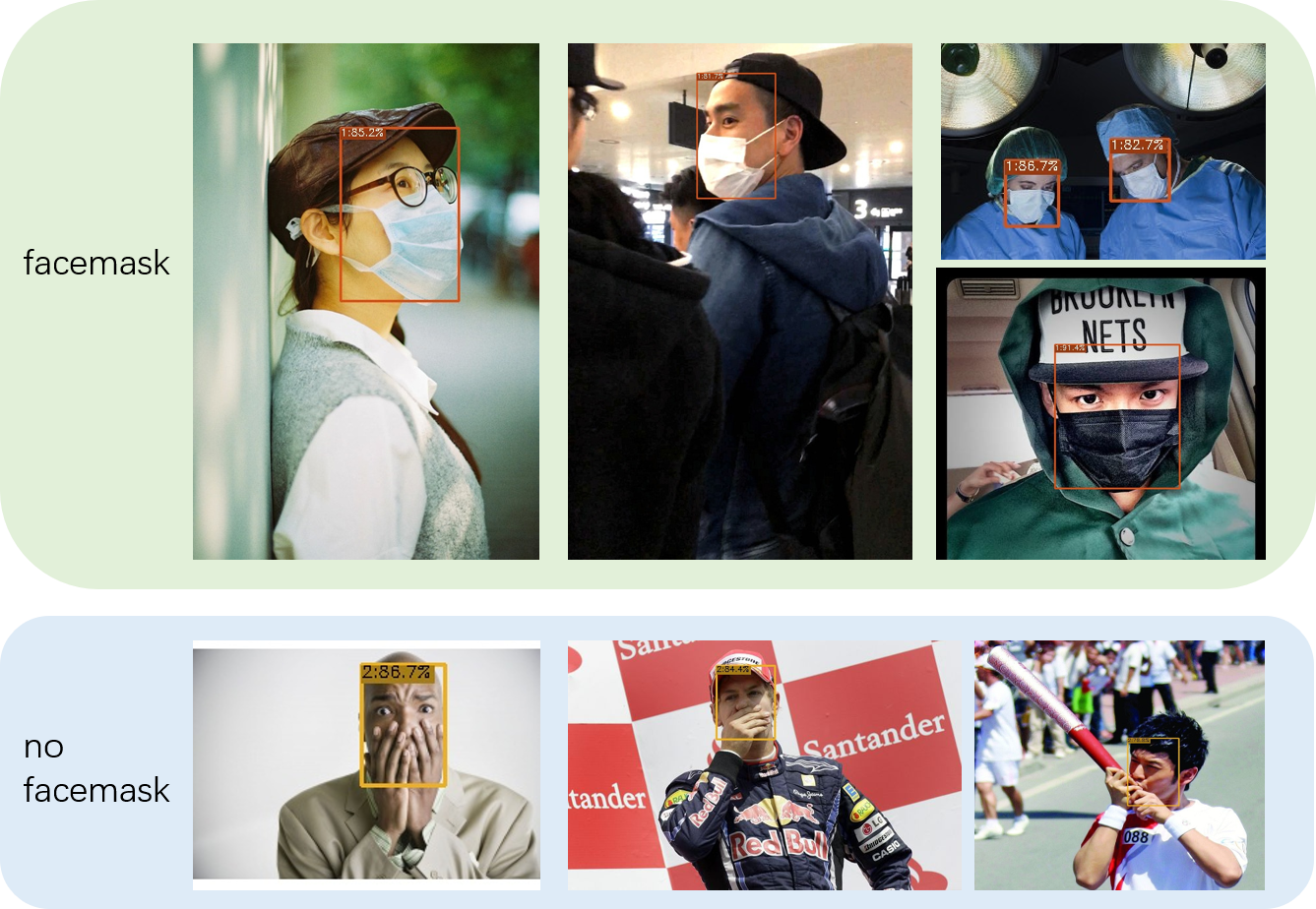

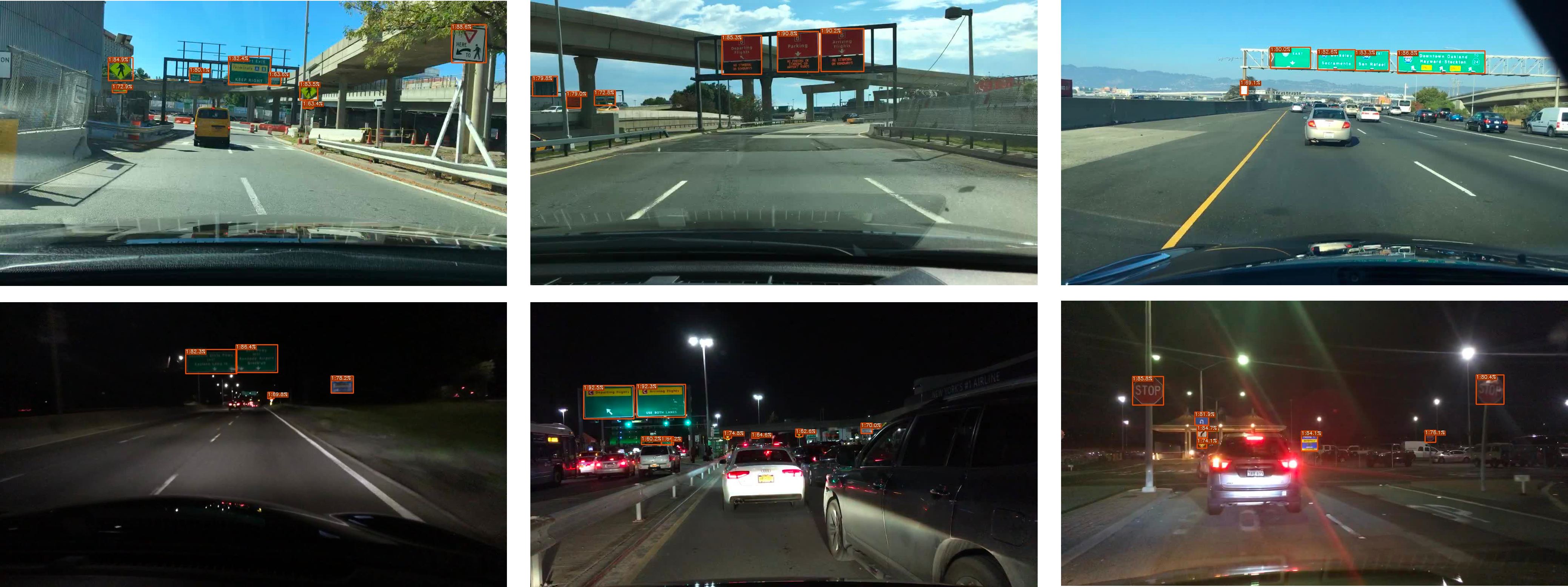

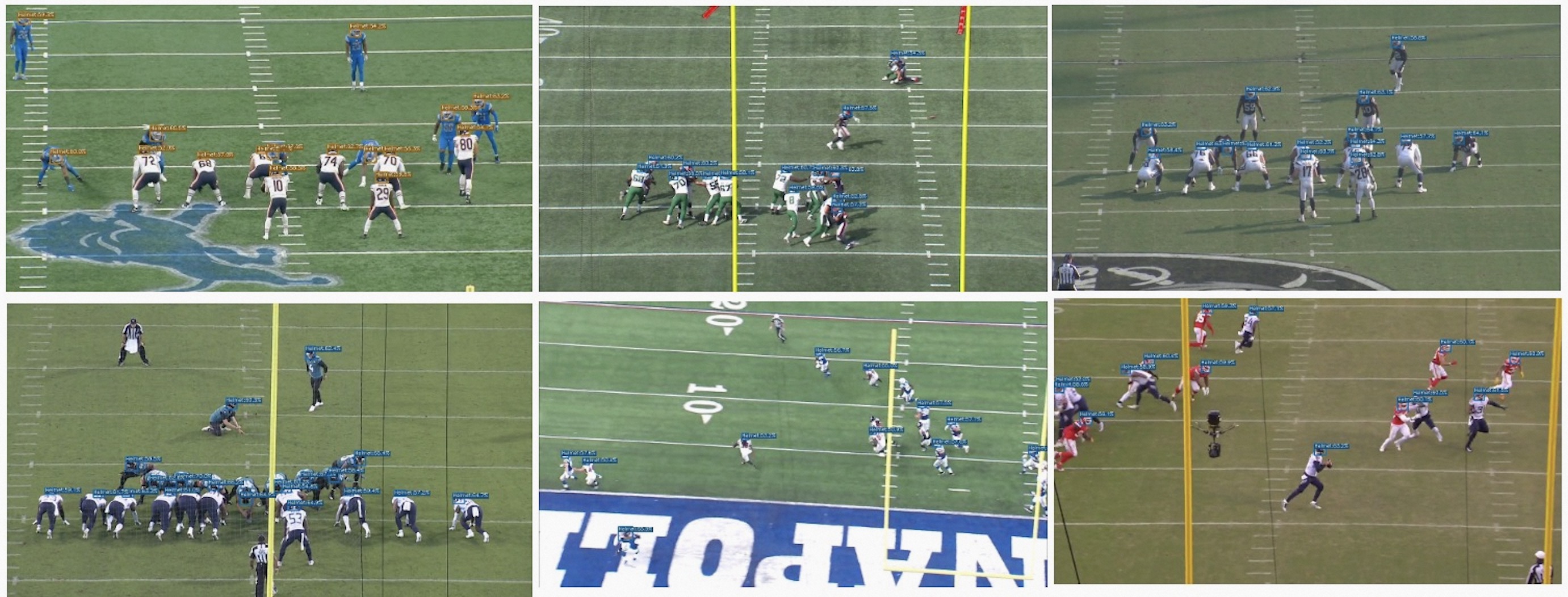

|[**口罩检测**](https://www.modelscope.cn/models/damo/cv_tinynas_object-detection_damoyolo_facemask/summary) |[**香烟检测**](https://www.modelscope.cn/models/damo/cv_tinynas_object-detection_damoyolo_cigarette/summary) | [**交通标识检测**](https://modelscope.cn/models/damo/cv_tinynas_object-detection_damoyolo_traffic_sign/summary) | [**NFL-头盔检测**](https://www.modelscope.cn/models/XianzheXu/cv_tinynas_object-detection_damoyolo_nfl-helmet/summary)|

|

|

|[**口罩检测**](https://www.modelscope.cn/models/damo/cv_tinynas_object-detection_damoyolo_facemask/summary) |[**香烟检测**](https://www.modelscope.cn/models/damo/cv_tinynas_object-detection_damoyolo_cigarette/summary) | [**交通标识检测**](https://modelscope.cn/models/damo/cv_tinynas_object-detection_damoyolo_traffic_sign/summary) | [**NFL-头盔检测**](https://www.modelscope.cn/models/XianzheXu/cv_tinynas_object-detection_damoyolo_nfl-helmet/summary)|

| |

|  |

| |

|  |

## 第三方资源

为了促进DAMO-YOLO用户间的交流,我们会定期收集汇总第三方资源到该板块,如果您有与DAMO-YOLO有关的原创内容,欢迎联系xianzhe.xxz@alibaba-inc.com。

- DAMO-YOLO总览:[幻灯片](https://idstcv.oss-cn-zhangjiakou.aliyuncs.com/DAMO-YOLO/slides/DAMO-YOLO-Overview.pdf),[视频](https://www.bilibili.com/video/BV1hW4y1g7za/?spm_id_from=333.337.search-card.all.click).

- [DAMO-YOLO代码解读](https://blog.csdn.net/jyyqqq/article/details/128419143)

- [DAMO-YOLO自有数据训练范例](https://blog.csdn.net/Cwhgn/article/details/128447380?spm=1001.2014.3001.5501)

## 实习生招聘

我们正在招聘研究型实习生,如果您对目标检测/模型量化/神经网络搜索等方向有兴趣,敬请将简历投递到xiuyu.sxy@alibaba-inc.com。

## 引用

```latex

@article{damoyolo,

title={DAMO-YOLO: A Report on Real-Time Object Detection Design},

author={Xianzhe Xu, Yiqi Jiang, Weihua Chen, Yilun Huang, Yuan Zhang and Xiuyu Sun},

journal={arXiv preprint arXiv:2211.15444v2},

year={2022},

}

@inproceedings{sun2022mae,

title={Mae-det: Revisiting maximum entropy principle in zero-shot nas for efficient object detection},

author={Sun, Zhenhong and Lin, Ming and Sun, Xiuyu and Tan, Zhiyu and Li, Hao and Jin, Rong},

booktitle={International Conference on Machine Learning},

pages={20810--20826},

year={2022},

organization={PMLR}

}

@inproceedings{jiang2022giraffedet,

title={GiraffeDet: A Heavy-Neck Paradigm for Object Detection},

author={yiqi jiang and Zhiyu Tan and Junyan Wang and Xiuyu Sun and Ming Lin and Hao Li},

booktitle={International Conference on Learning Representations},

year={2022},

}

```

|

## 第三方资源

为了促进DAMO-YOLO用户间的交流,我们会定期收集汇总第三方资源到该板块,如果您有与DAMO-YOLO有关的原创内容,欢迎联系xianzhe.xxz@alibaba-inc.com。

- DAMO-YOLO总览:[幻灯片](https://idstcv.oss-cn-zhangjiakou.aliyuncs.com/DAMO-YOLO/slides/DAMO-YOLO-Overview.pdf),[视频](https://www.bilibili.com/video/BV1hW4y1g7za/?spm_id_from=333.337.search-card.all.click).

- [DAMO-YOLO代码解读](https://blog.csdn.net/jyyqqq/article/details/128419143)

- [DAMO-YOLO自有数据训练范例](https://blog.csdn.net/Cwhgn/article/details/128447380?spm=1001.2014.3001.5501)

## 实习生招聘

我们正在招聘研究型实习生,如果您对目标检测/模型量化/神经网络搜索等方向有兴趣,敬请将简历投递到xiuyu.sxy@alibaba-inc.com。

## 引用

```latex

@article{damoyolo,

title={DAMO-YOLO: A Report on Real-Time Object Detection Design},

author={Xianzhe Xu, Yiqi Jiang, Weihua Chen, Yilun Huang, Yuan Zhang and Xiuyu Sun},

journal={arXiv preprint arXiv:2211.15444v2},

year={2022},

}

@inproceedings{sun2022mae,

title={Mae-det: Revisiting maximum entropy principle in zero-shot nas for efficient object detection},

author={Sun, Zhenhong and Lin, Ming and Sun, Xiuyu and Tan, Zhiyu and Li, Hao and Jin, Rong},

booktitle={International Conference on Machine Learning},

pages={20810--20826},

year={2022},

organization={PMLR}

}

@inproceedings{jiang2022giraffedet,

title={GiraffeDet: A Heavy-Neck Paradigm for Object Detection},

author={yiqi jiang and Zhiyu Tan and Junyan Wang and Xiuyu Sun and Ming Lin and Hao Li},

booktitle={International Conference on Learning Representations},

year={2022},

}

```