Chrome et Mozilla parlent de limiter les fonctionnalités de leurs navigateurs sur les sites qui n’utilisent pas SSL.

Sur le papier, c’est pavé de bonnes intentions : forcer les auteurs de sites à chiffrer la communication entre le serveur et le client. Plus de sécurité pour les utilisateurs, tant pis pour les dev paresseux, pas vrai ?

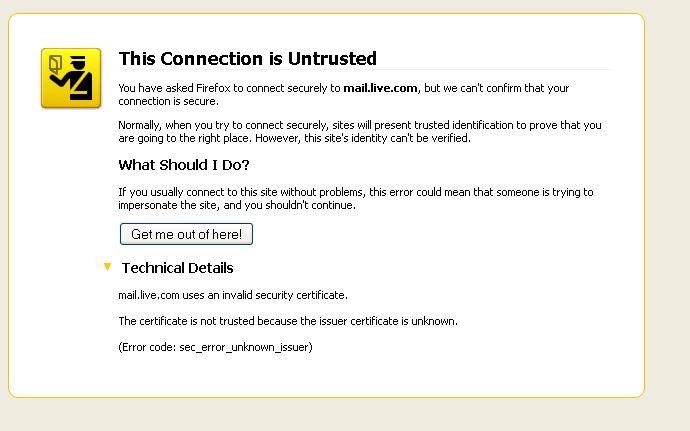

Sauf que HTTPS fonctionne sur le principe d’autorités centrales. Vous devez obtenir un certificat auprès d’une autorité de confiance, sans quoi le navigateur va afficher ça :

Michou ne va pas lire ce texte, encore moins chercher et trouver comment accéder au site. Elle va courir. Un virus !

Les moteurs de recherche vont vous plomber, l’utilisateur va fuir, bref, votre site est mort.

Et c’est la que ça devient fun, car les autorités centrales sont des organismes privés, et il n’y en a pas beaucoup. Ils ne sont pas tenus de vous filer un certificat, et peuvent le retirer à tout moment.

En clair, forcer SSL partout, c’est donner la main à quelques grosses boites pour décider qui a le droit d’être sur le Web ou pas. Vous voulez faire un truc qui ne leur plait pas ? Attention, montrer un tableau classique avec des nichons ne plait pas à Apple, faire un noeud Tor ne plait pas à Amazon, les bitcoins ne plaisent pas à Paypal et être gay ne plait pas à plein de gouvernements.

Toutes ces entités travaillent main dans la main avec les autorités de certification, et avoir Mozilla en proposer une n’y changera rien. Si vous faites un truc que ces gens ne veulent pas, vous effacer du Web sera aussi facile que de faire pression pour révoquer votre certificat.

Sans jugement. Sans procès. Sans recours possible.

Le Web deviendra un app store.

EDIT :

Je rajoute mon commentaire sur let’s encrypt ici sinon je sens que tout le monde va radoter

L’article a un lien qui pointe vers let’s encrypt. Ca ne change rien : c’est centralisé, privé, et subira des pressions comme tous les autres. J’aime Mozilla, j’ai confiance en eux, mais ils n’ont aucun moyen de garantir la neutralité de let’s encrypt, ne serait que par rapport aux gouvernements.

Et puis quoi ? A la fin tous les sites “border line” seront chez eux ? Comme ça bam, un bon single point of failure à attaquer pour tout faire tomber d’un coup ?

FBI. FBI. FBI.

Si un tel changement devait s’opérer alors le fonctionnement actuel autour d’autorités centrale privées et/ou payantes sera surement à revoir effectivement. L’un ne peut aller sans l’autre si on veut que le web continue de tourner.

Je vais peut etre dire une connerie, mais il me semble que Mozilla est l’une de ces autorité, et qu’il y a quelque mois qu’ils parlait de fournir aux demandeurs, des certificats gratuit afin d’aller dans le sens du HTTPS et de faciliter son déploiement.

L’article a un lien qui pointe vers let’s encrypt. Ca ne change rien : c’est centralisé, privé, et subira des pressions comme tous les autres. J’aime Mozilla, j’ai confiance en eux, mais ils n’ont aucun moyen de garantir la neutralité de let’s encrypt, ne serait que par rapport aux gouvernements.

Et puis quoi ? A la fin tous les sites “border line” seront chez eux ? Comme ça bam, un bon single point of failure à attaquer pour tout faire tomber d’un coup ?

FBI. FBI. FBI.

Fallait lire l’update tout en bas, et parcourir la FAQ :)

https://blog.mozilla.org/security/files/2015/05/HTTPS-FAQ.pdf

TL;DR: Mozilla pousse dans ce sens car il sait que la situation des CA va changer avec let’s encrypt.

Bon, je vais mettre mon commentaire sur let’s encrypt dans l’article, car sinon je sens que les paresseux vont continuer de le mentionner en comment.

En prime je ne parle pas dans l’article de :

Pour les grosses boites style Amazon, Google et co., le SSL permet d’éviter que leurs services ne soient (trop) altérés entre leurs serveurs et les utilisateurs finaux, les FAI ayant très envie de pratiquer des tarifications à l’acte à l’instar des filles de joie.

Mais le jour où il faudra vraiment s’inquiéter, c’est quand les navigateurs refuseront d’installer nos propres CA.

Note que ce n’est pas une attaque contre SSL, qui est la pire des solutions à l’exception de toutes les autres, mais contre l’usage forcé de SSL.

Je vais peut être paraître con, qui sait..

Mais si cette volonté d’imposer le SSL est juste une “arme” pour se défendre du pecno lambda qui saurait utiliser Wireshark dans le réseau de son voisin. Pourquoi faire autant la chasse aux certificats auto-signés ?

Parce que là, oui, la neutralité du net en prend un coup. On recentralise encore plus un internet déjà à la bote de grosse firme. Mais ce coup ci, on tue les petits sites, blogs, etc…

Car là, y a même pas à parler des sites illégaux, car simplement, si un nouveau blogueur n’a simplement pas encore les testicules pour obtenir son certificat ; il se retrouve sur le tapis avant même d’avoir commencé son activité.

Mais depuis un trop long moment, les navigateurs ont décidé de faire la chasse aux certificats auto-signés.

Pourtant, comme l’a très bien expliqué Timo van Neerden, dans son article « Https sur mes sites » :

Donc, pour finir mon charabia qui commence à partir dans tous les sens ; si la volonté première est simplement de garantir la “confidentialité” des échanges, pourquoi ne pas arrêter cette chasse aux certificats auto-signés plutôt que de créer un nouveau péage qui ne changerais rien au problème ?

Le chiffrement généralisé permet surtout de passer d’une surveillance de masse à une surveillance ciblée, ça coûte beaucoup plus cher d’analyser du trafic chiffré que du trafic en clair.

De plus, c’est pas plus centralisé que les registrars (tiens, gandi est registrar et vend aussi des certificats). Aussi, j’ai un site web avec un certificat CAcert et google ne me déréférence pas.

Et les registrars sont déjà un problème : quand un américain veut te faire chier, il fait pression sur ton registrar pour te retirer ton nom de domaine. Avec Max on a le problème en ce moment même, et croyez moi, c’est pas rigolo. Avec les certificats, se sera bien pire, car le nombre d’autorités est plus réduit, et il n’y a pas de législation par pays comme sur l’attribution des noms de domaine.

Enfin, je n’ai jamais dis que google te déférencerait. Mais le nombre de personnes qui vont bouncer sur ton site va augmenter, le nombre de lien pointant vers le site va diminuer, et les moteurs de recherche vont le détecter et te plomber. C’est mécanique.

Je pense que beaucoup de gens ne se rendent pas compte de la problématique parce qu’ils :

Mais si demain le Web devient un app store, ce que vous pourrez y lire aura la même qualité que la télévision.

C’est déjà en train de se produire avec les registrars, les take down notices et toute sorte d’autres abus. Là on parle simplement de troquer un missile sol-air contre une ogive nucléaire.

Par ailleurs, si un chiffrement généralisé de qualité permettrait d’éviter la surveillance de masse, le chiffrement via SSL ne le permet pas.

En effet, un gouvernement a juste à générer des certificat validé par les registrars pour chaque site visité. On sait depuis Prism qu’ils le font. C’est un peu d’infrastructure en plus :

Je pense que ça va aller, entre deux boites noires installées avec la nouvelle loi sur la sécurité numérique, il vont trouver le temps de coder ça.

Et les autorités de certif n’auront rien le droit de dire, car c’est pour lutter contre le terrorisme et la pédophilie. Même Mozilla, qui n’aura plus que ses warrant canaris pour pleurer.

Depuis quelque temps ils font des trucs border line chez mozilla. Et avec Nitot qui a quitté le navire, je commence à me demander si il y a pas eu des changements sur la philosophie en interne.

Bon, ne tombons pas dans la parano, mais tout de même, faut faire gaffe à ce genre de mesure.

Faudrait déjà que les navigateurs implémentent DANE (en gros on met le certificat dans le DNS, donc pas besoin de CA). Mais ça implique de déployer DNSSEC, d’où l’argument de la simplicité.

Je plusunise DANE.

cf ici pour la critique de X.509 et l’explication de DANE http://www.bortzmeyer.org/6698.html

EN gros il s’agit d’un système qui consiste à mettre un hash (sha256 par example) du certificat dans les DNS.

Et celui ci complète ou remplace la ça. Si le certificats et la vérification corresponde, alors le certificats est valable. L’avantage est que une organisation peut générer un certificat signé pour notre domaine, si la vérification ne correspond pas alors ça ne marchera pas.

On déplace donc la confiance du certificat vers les DNS. Hors beaucoup save que les dns peuvent être protégé via DNSEC ce qui empèche le spoofing DNS (se faire passer par un serveur DNS et donner des fausses résolutions).

OVH et gandhi implémentent de base DNSEC et le champs TLSA pour DNSSEC ne saurait venir.

Si letsencryptevrything permet de hater la transition de X.509 pourri vers un truc plus fiable alors je suis 100% pour. C’est sur que ça demandera des outils pour rendre le truc accessible mais on peut déja imaginer une libraireie en python qui prend en arguments le certificats et le domaine et gènère directement des zones bind ou se connecte à l’api ovh / gandhi / insert_registar_here pour mettre à jour le champs TLSA.

Et ci sa ce trouve ça existe déja, je le fais manuellement cr c’est comme openssl, on apprend en utilisant les outils pourri à la source mais nul doute qu’une voie plus accessible à du être trouvée :)

Ca va dans le sens de la stratégie des navigateurs concernant HTTP/2… Pour citer Wikipedia :

De bonnes intentions sur le papier… En pratique ce sera surement très moche.

“Depuis quelque temps ils font des trucs border line chez mozilla. Et avec Nitot qui a quitté le navire, je commence à me demander si il y a pas eu des changements sur la philosophie en interne.”

Entierement d’accord avec Sam. Je commence a serieusement me poser des questions sur Mozilla, encore plus depuis que ces derniers interdiront les extensions non signées ds firefox :\

Merci pr cet article, ça fait prendre du recul.

Je m’y connais pas beaucoup, mais y a pas moyen de mettre en place des certificats décentralisés en torrent (par exemple) ?

Le medium de transport n’est pas la plus grosse problématique. Le problème est qu’il faut qu’à un moment, l’outil ou l’entité que tu utilises pour vérifier les certificats soit de confiance. Bitcoin règle ça par exemple avec la block chain, en tablant que au moins 51% du réseau est de confiance et en délégant à chaque client la tache de valider qui a fait quoi. Je ne sais pas quelle serait une bonne solution alternative, mais j’ai tendance penser que le problème est plus politique / sociale que technique :

Et je gage que beaucoup de personnes ont interêt à ce que ça ne se fasse pas, donc la tache est rendue encore plus difficile.

Régler ces problèmes il y a 20 ans étaient plus faciles: des passionnés et experts se regoupaients, faisait du mieux qu’ils pouvaient, et on les rejoignaient quand ça marchait. Maintenant qu’Internet est une source énorme de revenus et de pressions politiques, ça ne se passe plus comme ça.

C’est sûr que les CA ont pas forcément envie que DANE les remplacent, du moins pour les petits sites…

Dans tous les cas le certificat ne garantit finalement pas tant que ça la fiabilité, en tout cas de ce que j’en sais.

On a déjà eu des cas d’usurpation de certificat…

(pas récent mais qui me revient forcément en mémoire après lecture de l’article)

http://sebsauvage.net/rhaa/?2011/03/23/21/58/46-la-foire-aux-certificats-ssl-continue

Cela signifie quoi en gros? Qu’une autorité centrale ne pourra globalement pas garantir définitivement la sécurité, et que cela en fera forcément un détenteur de pouvoirs énormes.

Je suis donc “contre” l’usage en masse du certificat, cependant je ne me poserai pas en expert car il me semble qu’ils sont très utiles dans des cas précis: commerce électronique, échanges sécurisés…

Concernant Mozilla et les pressions, c’est le même problème que Wikipedia : une entitée US, donc déjà une juridiction qui concentre de fait un certain nombre de “dirigeants/géants/pouvoirs sur le Net” (ICANN, toussa), & en plus une centralisation (Mozilla et ses services direct ou annexes, letsencrypt, etc) par ailleurs.

Ils leur est donc d’autant plus facile de faire pression, d’une manière ou d’une autre.

Sans vouloir faire le parano, j’ai une autre lecture des grosses boites type google qui communique autour du SSL.

Je pense qu’elle le font surtout comme moyen de négociation/pression sur les gouvernements :

Les gouvernements et leurs agences de renseignement veulent forcer les grosses boites à fournir des accès directe, des possibilités d’écoute etc. Puisque le cauchemar des NSA et consorts, c’est que tout soit crypté : elles utilisent leurs puissances médiatiques pour compliquer le travail d’écoute.

Quand Google a annoncé qu’ils allaient favoriser les sites en https, pas un mec en SEO n’a vu un changement.

Quant à Mozila, j’aimerai rappeler que leur business, c’est aussi de vendre aux autorités de certifications (verisign, mais aussi google) l’inclusion par défaut de leurs certificats racine.

Cela dit, après avoir vérifié, Mozzila affirme le contraire sur les certificats racine… il me semblais pourtant

https://www.mozilla.org/en-US/about/governance/policies/security-group/certs/policy/inclusion/

We will not charge any fees to have a CA’s certificate(s) distributed with our software products.

Pour moi, c’est du n’importe quoi, le chiffrement des communications c’est la base pour ne pas être surveillé massivement, il me semble que c’est une question plus importante que celle du pouvoir qu’on donne à des CA, car on restant totalement surveillé, on s’expose directement au possible contrôle de tout ceux qui nous observent. Une communication chiffrée sera, à ce niveau, bien plus efficace contre le gain de pouvoir de certain, plus bénéfique. Ensuite, le problème vient des navigateurs, pourquoi ne peut-on pas avoir un certificat auto-signé sans que le navigateur affiche une page qui laisse penser que toutre votre famille va mourir si on poursuit notre navigation ? C’est une mauvaise stratégie selon moi et c’est tout. Je me fie à une extension pour gérer les certificats et les autorités auxquelles je crois, car lorsque je visite les sites de mes amis qui sont tous accessibles uniquement en HTTPS, je voyais cette page chiante à souhait, invivable. On a pas ce genre de problème lorsqu’on fait son propre DNS, mon navigateur ne me dis pas “Oups, votre requête DNS a été initié par un serveur qui n’est pas digne de confiance, voulez-vous vraiment continuer”. C’est un peu l’idée que j’en ai, ma priorité, qui n’est pas forcément celle de tous bien sûr, c’est de masquer le contenu de mes visites.

Pour parler de la différence entre un petit site et une usine, c’est certes très différents, mais cela n’empêche pas que ça marche aussi en adaptant la recette, dans ma boîte, nous avons également notre site et entièrement en HTTPS, et comme nous ne sommes qu’une centaine, et nullement l’envie de payer pour un certificat qu’on peut créer nous-même, nous l’avons monté et inséré dans tous les smartphones professionnels et les ordinateurs liés à la boîte, comme ça pas de soucis, nous avons un tout petit espace visible en clair sur Internet pour les clients, mais l’espace de forum par exemple est uniquement en HTTPS, donc une personne externe, sois elle accepte la connexion, sois elle s’en va. Je pense que la seconde grosse partie du problème c’est l’éducation des personnes (comme toujours) qui vont sur Internet.

Et pour ne pas les laisser être éduquer par les recommandations Facebook, Google, etc. il faut masquer leurs communications.

CQFD

Tu n’as visiblement pas lu les commentaires précédents expliquant que SSL était cassé et ne permettait pas d’empêcher la surveillance.

Par ailleurs, ce n’est pas une attaque de la crypto, mais sur le fait d’imposer SSL.

Dans ton cas, tu parles d’SSL en entreprise. Et imposer SSL ne pose pas de souci en entreprise, car il on a le contrôle de l’environnement. Ce n’est pas le cas sur le Web. Cela rajoute une protection désirable contre le piratage.

Note également que je ne dis pas que SSL est une mauvaise chose, je suis content qu’il chiffre mes connexions bancaires, je dis que l’imposer est une mauvaise chose. Cela n’aidera en rien la sécurité des gens, et va créer un web app store.

Ne mélange pas tout.

Justement j’ai bien lu, et le problème de SSL n’est pas qu’il est cassé, car c’est une bonne technologie, mais le soucis est que son implémentation est, à 90% du temps, mauvaises, d’où l’amalgamme que je peux lire partout.

Et un problème qui revient tout le temps, c’est la confiance, on donne la responsabilité d’autorité de gérer la confiance, hors le meilleur exemple pour avoir une confiance qui fonctionne bien mieux ce sont les clés de chiffrement GPG, là on parle d’une confiance sociale et non commerciale.

Effectivement, tu as raison, c’est mieux formulé ainsi : c’est l’implémentation qui est cassé, car le chiffrement, lui marche.

Nous allons vers le HTTPS, et ce n’est pas une connerie, c’est une excellente chose pour la sécurité des connexions. Tu peux toujours utiliser CaCert (http://www.cacert.org/), si tu as peur de LetsEncrypt. En fait, c’est juste que tu commences à avoir peur de la technologie. D’ailleurs, je ne sais pas pourquoi, je vais sur un blog non HTTPS. Soutenir le HTTP non sécurisé est une grosse connerie : je ne jouerai pas la carte de l’attentisme. Le HTTPS est une évolution nécessaire et l’IETF se fera un plaisir de corriger les ridicules points négatifs de ce protocole sécurisé.

Encore une fois, je ne dis pas que HTTPS est une grosse connerie, je l’utilise tous les jours avec mes clients et serveurs. Merci de lire l’article et les commentaires soigneusement. Je dis que forcer son usage l’est. C’est un problème politique et social, pas technique. On pourrait croire qu’avec les DRM, les brevets, et les lois sur le renseignement les techniciens commenceraient à voir venir une méthode de verrouillage grosse comme une maison…

Même si on utilise un certificat bidons et que il faut accepter une première fois le cert on est mieux que sans https.

on est protégé contre le serveur spoofing et on peut éviter un man in the middle attack (L’attaque de l’homme du milieu)

(sauf bien-sur pendant la premier connexion ou on peut pas être sur de certificat)

Pour moi c’est déjà gagnant mieux que aujourd’hui. Si tout le trafic web est encrypté on réduit a mon avis énormément la surveillance non ciblée qui concerne la majorité entre nous.

Je vais répéter ce que j’ai dis plus haut alors, parce que faut que ça rentre :

D’un point de vue technique, je ne comprends jamais la différence entre les certificats ssl à 10€ et ceux à 250€. Sur les sites de vendeurs de certificats, ils se contentent de dire que les certificats chers ont une sécurité cinq étoiles alors que les pas chers trois.

Si quelqu’un a un lien vers une explication concrète et sans bullshit, je suis prenneur.

@Gring : Je ne pense pas que la différence soit technique, mais plutôt qu’elle se distingue en fonction du protocole de validation suite à une demande de certificat. Si l’autorité doit envoyer quelqu’un au siège d’une entreprise pour vérifier que la demande de cette dernière est réelle (pas une usurpation), normal que ça coûte plus cher ! :D Du coup, la méthode de vérification est renseignée dans le certificat pour que des logiciels ajoutent des étoiles, mettent une meilleure note ou une plus jolie couleur lorsque la suite cryptographique est analyée.

Nous ne serons jamais d’accord. HTTPS ne rentre pas dans le champ politique et social. Il est vain d’intellectualiser et d’échapper HTTPS de son cadre technique. HTTPS avec TLS est plus sécurisé que HTTP, le principe des autorités centrales peut être remis en cause mais c’est une avancée. L’informatique n’adopte pas assez vite les standards, c’est une excellente idée que de forcer leur adoption par tous les moyens. C’est pas comme si l’adoption d’IPv6 n’était pas ralentie. A un moment, les grands acteurs doivent prendre des décisions responsables, et faire du mieux pour que la technologie avance et que la fracture numérique se réduise. Jusqu’à présent, HTTPS profite aux internautes dans la plupart des cas : c’est le statu quo. Avec la surveillance numérique propulsée au filtrage par DPI, tous les moyens de chiffrement sont bons pour être protégés. Tu remets en question de manière ridicule le forcing vers HTTPS. Tout n’est pas noir, tout n’est pas blanc. Il y aura toujours des alternatives, des garde-fous qui nous empêcheront d’être ce que nous critiquons.

En effet. Je ne serai jamais d’accord avec une vision purement technique du monde. Il y a des humains derrière les machines, c’est pour ça que les majors l’emportent toujours sur le long terme et que les geeks restent entre eux. Les majors jouent la carte des humains, et les geeks jouent la carte de la technique. La première gagne toujours.

Je crois que personne n’a de “vision purement technique du monde”.

Non, les majors ne l’emportent pas toujours sur le long terme. Lorsqu’il s’agit de logiciel libre et de gouvernance ouverte, nous pouvons avoir des projets libres comme Popcorn Time (streaming vidéo) et Atraci (streaming musical) qui perdurent malgré l’agressivité des majors. Le fork de Firefox Pale Moon ne supportera pas les Encrypted Media Extensions. ThePirateBay est revenu des morts en février 2015… https://ploum.net/lorsque-lindustrie-fait-son-deuil/

Le chiffrement sera requis (TLS 1.2 et supérieur) pour HTTP2 grâce à l’implémentation des clients : https://en.wikipedia.org/wiki/HTTP/2#Encryption_2 : on ne suivra pas ton avis.

Tous les exemples que tu cites ne concernent qu’une minorité de personnes : les gens qui s’y connaissent en technique. Mais au final les DRM sont quand même intégré dans Firefox, le blocage DNS est quand même arrivé en France, la loi sur la surveillance numérique est passé, les systèmes libres et ouverts sont toujours la minorité (et des versions plus verouillées font du pognon chez les majors), les petits sites de video se mangent des DMCA tous les jours, les majors se sont bien sponsorisés sur l’hadopi qui n’a servi qu’à remplir leurs poches, la plupart des contenus sont vendus via des media verrouillés (itunes, netflix…), les appareils les plus vendus sont des ordinateurs bridés (les téléphones et tablettes) et snowden est toujours un fugitif. Tu peux compter les virgules (forks, bidouillages de contournement, avancées techniques temporaires, petits communautés solidaires) tant que tu veux, quand on est sur des puissances de 10, ça n’influence pas les scores.

Et oui, HTTPS sera requis pour HTTP2, alors que ce n’est pas nécessaire. Je sais que mon avis ne sera pas pris en compte, ça ne veut pas dire qu’il ne faut pas l’exprimer.

@Sam

Je suis bien d’accord sur ces points, nous restons une minorite, les gros et les gouvernements continuent de faire rentrer le poisson.

Le HTTPS requis pour HTTP/2 c’est tres dommage, car TLS et HTTP sont differents, le HTTP/2 devient un nouveau protocole a lui seul et c’est un probleme, surtout pour remplacer un protocole si largement utilise.

Et bien sur, un avis différent est justement celui qu’il faut exprimer le plus, ça permet de prendre plus de chose en compte.

Je crois malgré tout que l’accoutumance à la dictature n’est pas majoritaire. Nous, en tant que communauté libriste, sommes une minorité, mais la majorité silencieuse est là, et ne laissera pas tout faire, car elle agit, et agira toujours pour ses valeurs et ne sera jamais aliéné par l’aristocratie de l’argent. Ou du moins, par l’insurrection des consciences, la majorité silencieuse prend acte de ses faiblesses et se révolte en conséquence.

Mais concrètement comme solution, pourriez-vous proposer des alternatives ? Ou peut-être que si elle existait ça se saurait.

Et pour celui qui aimerait faire son site de manière décentralisé sans passer ni par HTTP car c’est en clair sur le réseau, ni en HTTPS à cause du fonctionnement actuel, ni en utilisant lestencrypt car single point of failure, il y a quoi comme possibilité ?